¿Son adecuados los chatbots de IA para los hospitales?

Probada la capacidad de diagnóstico de los grandes modelos lingüísticos

Los grandes modelos lingüísticos pueden aprobar exámenes médicos con nota, pero utilizarlos para hacer diagnósticos sería actualmente una grave negligencia. Los chatbots médicos hacen diagnósticos precipitados, no se atienen a las directrices y pondrían en peligro la vida de los pacientes. Esta es la conclusión a la que ha llegado un equipo de la TUM. Por primera vez, han investigado sistemáticamente si esta forma de inteligencia artificial (IA) sería adecuada para la práctica clínica diaria. A pesar de las deficiencias actuales, los investigadores ven potencial en esta tecnología. Han publicado un método que puede utilizarse para comprobar la fiabilidad de futuros chatbots médicos.

Los grandes modelos lingüísticos son programas informáticos entrenados con cantidades masivas de texto. Ahora, variantes especialmente entrenadas de la tecnología que hay detrás de ChatGPT incluso resuelven exámenes finales de estudios médicos casi sin fallos. Pero, ¿podría una IA de este tipo asumir las tareas de los médicos en una sala de urgencias? ¿Podría ordenar las pruebas adecuadas, hacer el diagnóstico correcto y crear un plan de tratamiento basado en los síntomas del paciente?

Un equipo interdisciplinar dirigido por Daniel Rückert, catedrático de Inteligencia Artificial en Asistencia Sanitaria y Medicina de la TUM, aborda esta cuestión en la revista "Nature Medicine". Por primera vez, médicos y expertos en IA investigaron sistemáticamente el éxito de las distintas variantes del modelo de lenguaje de código abierto Llama 2 a la hora de realizar diagnósticos.

Recreación del camino desde urgencias hasta el tratamiento

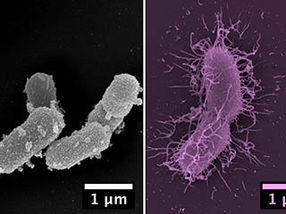

Para probar las capacidades de estos complejos algoritmos, los investigadores utilizaron datos anónimos de pacientes de una clínica de EE.UU.. Seleccionaron 2.400 casos de un conjunto de datos más amplio. Todos los pacientes habían acudido a urgencias con dolor abdominal. La descripción de cada caso terminaba con uno de cuatro diagnósticos y un plan de tratamiento. Los casos disponían de todos los datos registrados para el diagnóstico, desde la historia clínica y los valores sanguíneos hasta los datos de imagen. "Preparamos los datos de tal forma que los algoritmos pudieran simular los procedimientos reales y los procesos de toma de decisiones en el hospital", explica Friederike Jungmann, médico adjunto del departamento de radiología de la Klinikum rechts der Isar de la TUM y autora principal del estudio junto con el informático Paul Hager. "El programa sólo disponía de la información que tenían los médicos reales. Por ejemplo, tenía que decidir por sí mismo si pedía un hemograma y luego utilizar esta información para tomar la siguiente decisión, hasta que finalmente creaba un diagnóstico y un plan de tratamiento."

El equipo descubrió que ninguno de los grandes modelos lingüísticos solicitaba sistemáticamente todos los exámenes necesarios. De hecho, los diagnósticos de los programas eran menos precisos cuanta más información tenían sobre el caso. A menudo no seguían las pautas de tratamiento, y en ocasiones ordenaban exámenes que habrían tenido graves consecuencias para la salud de los pacientes reales.

Comparación directa con los médicos

En la segunda parte del estudio, los investigadores compararon los diagnósticos de la IA de un subconjunto de datos con los diagnósticos de cuatro médicos. Mientras que estos últimos acertaron en el 89 por ciento de los diagnósticos, el mejor modelo de lenguaje amplio logró sólo el 73 por ciento. Cada modelo reconoció algunas enfermedades mejor que otras. En un caso extremo, un modelo diagnosticó correctamente la inflamación de la vesícula biliar sólo en el 13 por ciento de los casos.

Otro problema que descalifica los programas para su uso cotidiano es la falta de solidez: el diagnóstico realizado por un gran modelo lingüístico dependía, entre otras cosas, del orden en que recibía la información. Las sutilezas lingüísticas también influían en el resultado: por ejemplo, si se pedía al programa un "Diagnóstico principal", un "Diagnóstico primario" o un "Diagnóstico final". En la práctica clínica diaria, estos términos suelen ser intercambiables.

ChatGPT no probado

El equipo no probó explícitamente los grandes modelos lingüísticos comerciales de OpenAI (ChatGPT) y Google por dos razones principales. En primer lugar, el proveedor de los datos del hospital ha prohibido que los datos se procesen con estos modelos por motivos de protección de datos. En segundo lugar, los expertos aconsejan encarecidamente que solo se utilice software de código abierto para aplicaciones en el sector sanitario.

"Sólo con modelos de código abierto tienen los hospitales control y conocimientos suficientes para garantizar la seguridad de los pacientes. Cuando probamos modelos, es esencial saber qué datos se utilizaron para entrenarlos. De lo contrario, podríamos probarlos exactamente con las mismas preguntas y respuestas con las que se entrenaron. Por supuesto, las empresas mantienen sus datos de entrenamiento en secreto, lo que dificulta las evaluaciones justas", afirma Paul Hager. "Además, basar la infraestructura médica clave en servicios externos que actualizan y cambian los modelos a su antojo es peligroso. En el peor de los casos, un servicio del que dependen cientos de clínicas podría cerrar porque no es rentable."

Rápidos avances

El desarrollo de esta tecnología avanza rápidamente. "Es muy posible que en un futuro próximo un gran modelo lingüístico sea más adecuado para llegar a un diagnóstico a partir del historial médico y los resultados de las pruebas", afirma el profesor Daniel Rückert. "Por eso hemos puesto nuestro entorno de pruebas a disposición de todos los grupos de investigación que quieran probar grandes modelos lingüísticos en un contexto clínico". Rückert ve potencial en esta tecnología: "En el futuro, los grandes modelos lingüísticos podrían convertirse en herramientas importantes para los médicos, por ejemplo para discutir un caso. Sin embargo, siempre debemos ser conscientes de las limitaciones y peculiaridades de esta tecnología y tenerlas en cuenta a la hora de crear aplicaciones", afirma el experto en IA médica."

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.

Publicación original

Paul Hager, Friederike Jungmann, Robbie Holland, Kunal Bhagat, Inga Hubrecht, Manuel Knauer, Jakob Vielhauer, Marcus Makowski, Rickmer Braren, Georgios Kaissis, Daniel Rueckert; "Evaluation and mitigation of the limitations of large language models in clinical decision-making"; Nature Medicine, 2024-7-4