¿Ha salido el genio de la botella? ¿Se puede confiar en ChatGPT en la escritura científica?

Diferencias entre artículos veterinarios difíciles de determinar

Desde su lanzamiento en noviembre de 2022, ChatGPT, un modelo lingüístico de última generación desarrollado por OpenAI, L.L.C. en San Francisco, CA, EE.UU., ha acaparado la atención de la comunidad científica. Mientras surgen en todo el mundo debates sobre el impacto de ChatGPT en todos los aspectos del mundo académico, un equipo de la Universidad de Medicina veterinaria de Hannover (Alemania) dirige un proyecto con múltiples socios internacionales para explorar las posibles limitaciones y ventajas asociadas a la aplicación de ChatGPT en la escritura científica.

Este estudio, titulado "ChatGPT and Scientific Papers in Veterinary Neurology: Is the Genie Out of the Bottle?" publicado en Frontiers in Veterinary Science, Section Veterinary Neurology and Neurosurgery, investiga la capacidad de ChatGPT para generar artículos científicos en el campo de la neurología veterinaria.

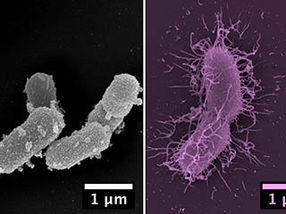

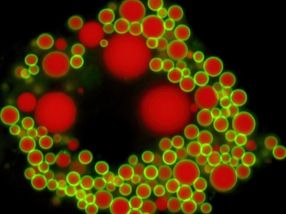

Se evaluaron los resúmenes y las secciones introductorias, incluidas las referencias, de tres artículos de investigación originales diferentes y de artículos generados por ChatGPT en neurología veterinaria mediante detectores de resultados de IA y detectores de plagio. También se pidió a trece neurólogos certificados que determinaran la originalidad y fiabilidad del contenido.

"Estamos encantados de que este trabajo se haya publicado a principios del curso académico. Como cualquier otra tecnología, una herramienta de IA como ChatGPT puede suponer una amenaza para la integridad y la transparencia científicas o ayudar a los investigadores, dependiendo de cómo se utilicen. Recomiendo encarecidamente la integración de la educación tanto en el uso adecuado como en el potencial mal uso de las herramientas basadas en IA en el mundo académico como un aspecto fundamental de la buena práctica científica." afirma Samira Abani, primera autora de la Universidad de Medicina Veterinaria de Hannover.

Jasmin Neßler, autora correspondiente de la Universidad de Medicina Veterinaria de Hannover, comenta: "Creemos que la popularidad de la IA requiere una colaboración científica interdisciplinar para establecer directrices claras para su uso responsable, garantizando la integridad y la transparencia en la literatura publicada. Prohibir las herramientas de IA puede no ser siempre el enfoque más eficaz para prevenir su uso indebido; en su lugar, deberíamos aprovechar esta oportunidad para aprovechar el potencial de la IA en beneficio de la sociedad."

El profesor Holger Volk, jefe de la Clínica de Pequeños Animales de la Universidad de Medicina Veterinaria de Hannover, añade: "Hemos aprendido que los grandes modelos lingüísticos (LLM) como ChatGPT están entrenados para imitar los estilos de escritura humanos y producir textos coherentes y plausibles, lo que a veces puede engañar a los expertos humanos. Sin embargo, los modelos como ChatGPT son propensos a la alucinación y pueden generar contenidos sesgados. Esto plantea dudas sobre la integridad de la utilización de este tipo de modelos en la escritura académica: debemos recordar que, a pesar de los recientes avances, debemos ser escépticos a la hora de confiar completamente en ChatGPT o en cualquier herramienta de IA, al menos por ahora."

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.

Publicación original

Samira Abani, Holger Andreas Volk, Steven De Decker, Joe Fenn, Clare Rusbridge, Marios Charalambous, Rita Goncalves, Rodrigo Gutierrez-Quintana, Shenja Loderstedt, Thomas Flegel, Carlos Ros, Thilo von Klopmann, Henning Christian Schenk, Marion Kornberg, Nina Meyerhoff, Andrea Tipold, Jasmin Nicole Nessler; "ChatGPT and scientific papers in veterinary neurology; is the genie out of the bottle?"; Frontiers in Veterinary Science, Volume 10, 2023-10-5