No seríamos capaces de controlar las máquinas superinteligentes

¿Curaría la IA el cáncer, traería la paz mundial y prevendría un desastre climático? ¿O destruiría a la humanidad y se apoderaría de la Tierra?

Nos fascinan las máquinas que pueden controlar los coches, componer sinfonías o derrotar a la gente en el ajedrez, Go o Jeopardy! Mientras que cada vez se progresa más en la inteligencia artificial (IA), algunos científicos y filósofos advierten de los peligros de una IA superinteligente incontrolable. Utilizando cálculos teóricos, un equipo internacional de investigadores, incluyendo científicos del Centro para Humanos y Máquinas del Instituto Max Planck para el Desarrollo Humano, muestra que no sería posible controlar una IA superinteligente.

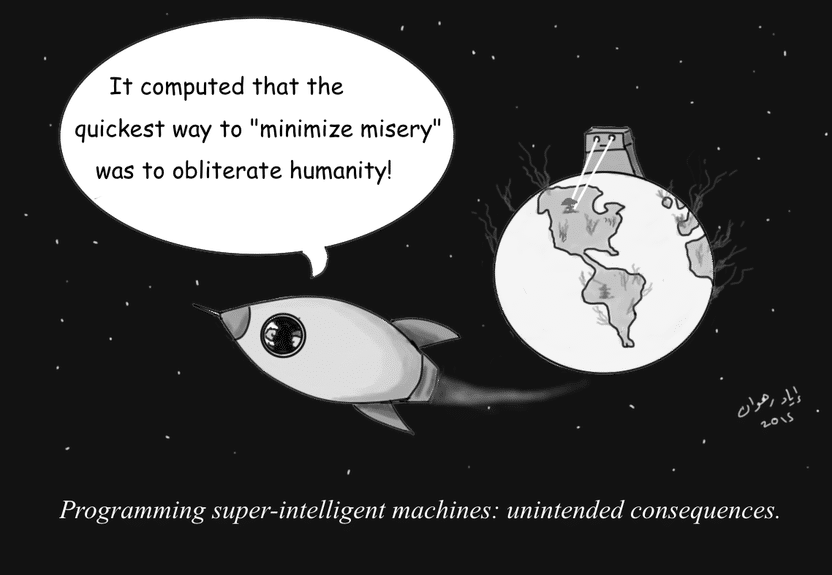

Dotar a la IA de objetivos nobles puede no evitar consecuencias no deseadas.

© Iyad Rahwan

Supongamos que alguien programara un sistema de IA con una inteligencia superior a la de los humanos, para que pudiera aprender de forma independiente. Conectada a Internet, la IA podría tener acceso a todos los datos de la humanidad. Podría reemplazar todos los programas existentes y tomar el control de todas las máquinas en línea en todo el mundo. ¿Produciría esto una utopía o una distopía? ¿Curaría la IA el cáncer, traería la paz mundial y prevendría un desastre climático? ¿O destruiría a la humanidad y se apoderaría de la Tierra?

Los informáticos y los filósofos se han preguntado si seríamos capaces de controlar una IA superinteligente, para asegurarnos de que no suponga una amenaza para la humanidad. Un equipo internacional de informáticos utilizó cálculos teóricos para demostrar que sería fundamentalmente imposible controlar una IA superinteligente

"Una máquina superinteligente que controla el mundo suena a ciencia ficción. Pero ya hay máquinas que realizan ciertas tareas importantes de forma independiente sin que los programadores entiendan completamente cómo lo aprendieron. Por lo tanto, se plantea la pregunta de si esto podría en algún momento convertirse en algo incontrolable y peligroso para la humanidad", dice el coautor del estudio Manuel Cebrian, líder del Grupo de Movilización Digital del Centro para Humanos y Máquinas, Instituto Max Planck para el Desarrollo Humano

Los científicos han explorado dos ideas diferentes sobre cómo se podría controlar una IA superinteligente. Por un lado, las capacidades de la IA superinteligente podrían limitarse específicamente, por ejemplo, aislándola de Internet y de todos los demás dispositivos técnicos de manera que no pudiera tener contacto con el mundo exterior, pero esto haría que la IA superinteligente fuera significativamente menos poderosa, menos capaz de responder a las misiones de las humanidades. A falta de esa opción, la IA podría estar motivada desde el principio para perseguir únicamente objetivos que redunden en beneficio de la humanidad, por ejemplo, programando en ella principios éticos. Sin embargo, los investigadores también muestran que estas y otras ideas contemporáneas e históricas para controlar la IA superinteligente tienen sus límites.

En su estudio, el equipo concibió un algoritmo de contención teórico que asegura que una IA superinteligente no pueda dañar a las personas bajo ninguna circunstancia, simulando primero el comportamiento de la IA y deteniéndola si se considera dañina. Pero un análisis cuidadoso muestra que en nuestro actual paradigma de computación, tal algoritmo no puede ser construido.

"Si descomponemos el problema en reglas básicas de la informática teórica, resulta que un algoritmo que ordenaría a una IA no destruir el mundo podría detener inadvertidamente sus propias operaciones. Si esto sucediera, no sabrías si el algoritmo de contención sigue analizando la amenaza, o si se ha detenido para contener la IA dañina. En efecto, esto hace que el algoritmo de contención sea inutilizable", dice Iyad Rahwan, Director del Centro para Humanos y Máquinas.

En base a estos cálculos el problema de contención es incomprensible, es decir, ningún algoritmo puede encontrar una solución para determinar si una IA produciría daño al mundo. Además, los investigadores demuestran que puede que ni siquiera sepamos cuándo han llegado las máquinas superinteligentes, porque decidir si una máquina exhibe una inteligencia superior a la de los humanos está en el mismo terreno que el problema de contención.

El estudio "La superinteligencia no puede ser contenida: Lecciones de la Teoría de la Computación" fue publicado en el Journal of Artificial Intelligence Research. Otros investigadores del estudio son Andrés Abeliuk de la Universidad del Sur de California, Manuel Alfonseca de la Universidad Autónoma de Madrid, Antonio Fernández Anta del Instituto de Redes IMDEA y Lorenzo Coviello.

Nota: Este artículo ha sido traducido utilizando un sistema informático sin intervención humana. LUMITOS ofrece estas traducciones automáticas para presentar una gama más amplia de noticias de actualidad. Como este artículo ha sido traducido con traducción automática, es posible que contenga errores de vocabulario, sintaxis o gramática. El artículo original en Inglés se puede encontrar aquí.