Comment la science peut-elle bénéficier de l'IA ?

Une publication met en garde contre les malentendus liés à l'utilisation d'algorithmes prédictifs

Les chercheurs en chimie, en biologie et en médecine se tournent de plus en plus vers les modèles d'IA pour élaborer de nouvelles hypothèses. Cependant, il est souvent difficile de savoir sur quelle base les algorithmes arrivent à leurs conclusions et dans quelle mesure elles peuvent être généralisées. Une publication de l'université de Bonn met en garde contre les malentendus liés à l'utilisation de l'intelligence artificielle. En même temps, elle met en évidence les conditions dans lesquelles les chercheurs peuvent avoir confiance dans les modèles. L'étude vient d'être publiée dans la revue Cell Reports Physical Science.

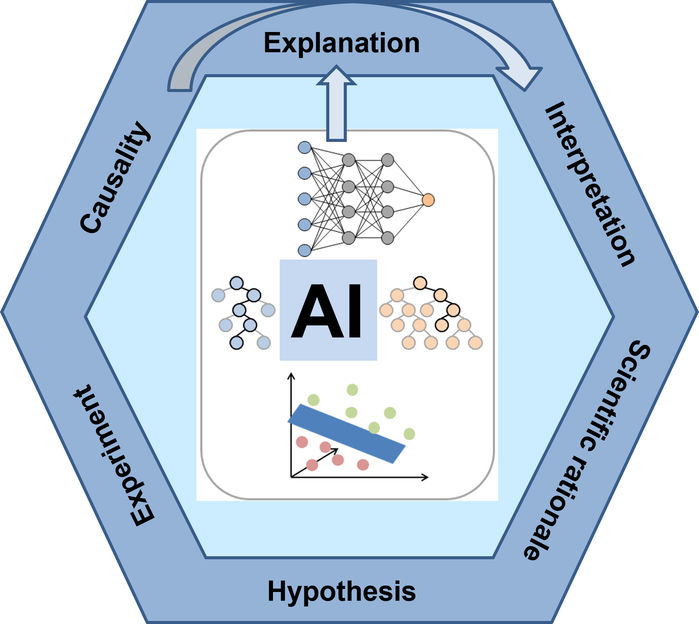

Les modèles d'IA dans les sciences naturelles : - De l'explication des prédictions à la saisie des relations causales.

Jürgen Bajorath/University of Bonn

Les algorithmes d'apprentissage automatique adaptatifs sont incroyablement puissants. Ils présentent néanmoins un inconvénient : la manière dont les modèles d'apprentissage automatique parviennent à leurs prédictions n'est souvent pas visible de l'extérieur.

Supposons que vous fournissiez à une intelligence artificielle des photos de plusieurs milliers de voitures. Si vous lui présentez une nouvelle image, elle est généralement en mesure de déterminer avec certitude si cette image représente également une voiture ou non. Mais pourquoi en est-il ainsi ? L'intelligence artificielle a-t-elle vraiment appris qu'une voiture a quatre roues, un pare-brise et un pot d'échappement ? Ou bien sa décision repose-t-elle sur des critères qui ne sont en fait pas pertinents, comme l'antenne sur le toit ? Si c'était le cas, elle pourrait également classer une radio dans la catégorie des voitures.

Les modèles d'IA sont des boîtes noires

"Les modèles d'IA sont des boîtes noires", souligne le professeur Jürgen Bajorath. "C'est pourquoi il ne faut pas se fier aveuglément à leurs résultats et en tirer des conclusions. L'expert en chimie informatique dirige le département "AI in Life Sciences" à l'Institut Lamarr pour l'apprentissage automatique et l'intelligence artificielle. Il est également responsable du programme d'informatique des sciences de la vie au Centre international des technologies de l'information de Bonn-Aachen (b-it) de l'université de Bonn. Dans la présente publication, il s'est penché sur la question de savoir quand on peut se fier aux algorithmes. Et inversement : quand ne pas le faire.

Le concept d'"explicabilité" joue un rôle important dans ce contexte. Métaphoriquement, il s'agit des efforts déployés par la recherche en IA pour percer un trou dans la boîte noire. L'algorithme doit révéler les critères sur lesquels il se base - les quatre roues ou l'antenne. "L'ouverture de la boîte noire est actuellement un thème central de la recherche en IA", explique M. Bajorath. "Certains modèles d'IA sont exclusivement développés pour rendre les résultats d'autres modèles plus compréhensibles.

L'explicabilité n'est toutefois qu'un aspect - la question de savoir quelles conclusions peuvent être tirées des critères de décision choisis par un modèle est tout aussi importante. Si l'algorithme indique qu'il a basé sa décision sur l'antenne, un être humain sait immédiatement que cette caractéristique est mal adaptée à l'identification des voitures. Malgré cela, les modèles adaptatifs sont généralement utilisés pour identifier des corrélations dans de grands ensembles de données que les humains ne remarqueraient même pas. Nous sommes alors comme des extraterrestres qui ne savent pas ce qu'est une voiture : Un extraterrestre serait incapable de dire si une antenne est un bon critère ou non.

Les modèles de langage chimique suggèrent de nouveaux composés

"Il y a une autre question que nous devons toujours nous poser lorsque nous utilisons des procédures d'IA en science", souligne Bajorath, qui est également membre du domaine de recherche transdisciplinaire (TRA) "Modélisation" : "Dans quelle mesure les résultats peuvent-ils être interprétés ? Les modèles de langage chimique sont actuellement un sujet brûlant dans la recherche chimique et pharmaceutique. Il est possible, par exemple, de les alimenter avec de nombreuses molécules ayant une certaine activité biologique. Sur la base de ces données d'entrée, le modèle apprend et suggère idéalement une nouvelle molécule qui possède également cette activité mais une nouvelle structure. C'est ce qu'on appelle la modélisation générative. Toutefois, le modèle ne peut généralement pas expliquer pourquoi il aboutit à cette solution. Il est souvent nécessaire d'appliquer par la suite des méthodes d'IA explicables.

Bajorath met toutefois en garde contre une surinterprétation de ces explications, c'est-à-dire contre le fait d'anticiper que les caractéristiques que l'IA considère comme importantes sont effectivement à l'origine de l'activité souhaitée. "Les modèles d'IA actuels ne comprennent pratiquement rien à la chimie", explique-t-il. "Ils sont de nature purement statistique et corrélative et prêtent attention à toute caractéristique distinctive, qu'elle soit ou non pertinente d'un point de vue chimique ou biologique. Malgré cela, ils peuvent même avoir raison dans leur évaluation - la molécule suggérée a peut-être les capacités souhaitées. Cependant, les raisons peuvent être complètement différentes de ce que nous attendrions sur la base de nos connaissances chimiques ou de notre intuition. Pour évaluer la causalité potentielle entre les caractéristiques qui déterminent les prédictions et les résultats des processus naturels correspondants, des expériences sont généralement nécessaires : Les chercheurs doivent synthétiser et tester la molécule, ainsi que d'autres molécules présentant le motif structurel que l'IA considère comme important.

Les contrôles de plausibilité sont importants

Ces tests prennent du temps et sont coûteux. Bajorath met donc en garde contre une surinterprétation des résultats de l'IA dans la recherche de relations causales scientifiquement plausibles. Selon lui, un contrôle de plausibilité basé sur un raisonnement scientifique solide est d'une importance cruciale : La caractéristique suggérée par l'IA explicable peut-elle réellement être responsable de la propriété chimique ou biologique souhaitée ? Cela vaut-il la peine de donner suite à la suggestion de l'IA ? Ou s'agit-il d'un artefact probable, d'une corrélation identifiée au hasard, comme l'antenne d'une voiture, qui n'est pas du tout pertinente pour la fonction réelle ?

Le scientifique souligne que l'utilisation d'algorithmes adaptatifs peut fondamentalement faire progresser la recherche dans de nombreux domaines scientifiques. Néanmoins, il faut être conscient des forces de ces approches - et surtout de leurs faiblesses.

Note: Cet article a été traduit à l'aide d'un système informatique sans intervention humaine. LUMITOS propose ces traductions automatiques pour présenter un plus large éventail d'actualités. Comme cet article a été traduit avec traduction automatique, il est possible qu'il contienne des erreurs de vocabulaire, de syntaxe ou de grammaire. L'article original dans Anglais peut être trouvé ici.