Le génie est-il sorti de sa bouteille ? Peut-on faire confiance au ChatGPT dans la rédaction scientifique ?

Différences entre les articles vétérinaires difficiles à déterminer

Depuis son lancement en novembre 2022, ChatGPT, un modèle linguistique de pointe développé par OpenAI, L.L.C. à San Francisco, CA, États-Unis, a attiré l'attention de la communauté scientifique. Alors que les débats sur l'impact de ChatGPT sur tous les aspects du monde universitaire se multiplient dans le monde entier, une équipe de l'Université de Médecine vétérinaire de Hanovre, en Allemagne, a mené un projet avec plusieurs partenaires internationaux pour explorer les limites et les avantages potentiels associés à l'application de ChatGPT dans la rédaction scientifique.

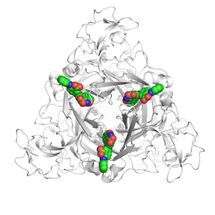

Cette étude, intitulée "ChatGPT and Scientific Papers in Veterinary Neurology : Is the Genie Out of the Bottle ?", publiée dans Frontiers in Veterinary Science, Section Veterinary Neurology and Neurosurgery, examine la capacité de ChatGPT à générer des articles scientifiques dans le domaine de la neurologie vétérinaire.

Les résumés et les sections d'introduction, y compris les références, de trois articles de recherche originaux différents et d'articles générés par ChatGPT dans le domaine de la neurologie vétérinaire ont été évalués à l'aide de détecteurs de sortie d'IA et de détecteurs de plagiat. Treize neurologues certifiés ont également été invités à déterminer l'originalité et la fiabilité du contenu.

"Nous sommes ravis que ce travail ait été publié au début de l'année universitaire. Comme toute autre technologie, un outil d'IA tel que ChatGPT peut soit constituer une menace pour l'intégrité et la transparence scientifiques, soit aider les chercheurs, en fonction de la manière dont il est utilisé. Je recommande vivement l'intégration de l'éducation sur l'utilisation correcte et l'abus potentiel des outils basés sur l'IA dans le milieu universitaire comme un aspect fondamental de la bonne pratique scientifique". Samira Abani, premier auteur de l'Université de médecine vétérinaire de Hanovre, déclare.

Jasmin Neßler, auteur correspondant de l'Université de médecine vétérinaire de Hanovre, commente : "Nous pensons que la popularité de l'IA nécessite une collaboration scientifique interdisciplinaire afin d'établir des lignes directrices claires pour son utilisation responsable, en garantissant l'intégrité et la transparence dans la littérature publiée. Interdire les outils d'IA n'est pas toujours l'approche la plus efficace pour prévenir les abus ; nous devrions plutôt saisir cette occasion d'exploiter le potentiel de l'IA au profit de la société."

Holger Volk, chef de la clinique des petits animaux à l'université de médecine vétérinaire de Hanovre, ajoute : "Nous avons appris que les grands modèles de langage (LLM) tels que ChatGPT sont formés pour imiter les styles d'écriture humains et produire des textes cohérents et plausibles, ce qui peut parfois tromper les experts humains. Cependant, les modèles comme ChatGPT sont sujets à des hallucinations et peuvent générer un contenu biaisé. Cela soulève des inquiétudes quant à l'intégrité de l'utilisation de ces modèles dans la rédaction académique - nous devons nous rappeler que, malgré les progrès récents, nous devrions être sceptiques quant à l'utilisation de ChatGPT ou de tout autre outil d'IA, du moins pour l'instant.

Note: Cet article a été traduit à l'aide d'un système informatique sans intervention humaine. LUMITOS propose ces traductions automatiques pour présenter un plus large éventail d'actualités. Comme cet article a été traduit avec traduction automatique, il est possible qu'il contienne des erreurs de vocabulaire, de syntaxe ou de grammaire. L'article original dans Anglais peut être trouvé ici.

Publication originale

Samira Abani, Holger Andreas Volk, Steven De Decker, Joe Fenn, Clare Rusbridge, Marios Charalambous, Rita Goncalves, Rodrigo Gutierrez-Quintana, Shenja Loderstedt, Thomas Flegel, Carlos Ros, Thilo von Klopmann, Henning Christian Schenk, Marion Kornberg, Nina Meyerhoff, Andrea Tipold, Jasmin Nicole Nessler; "ChatGPT and scientific papers in veterinary neurology; is the genie out of the bottle?"; Frontiers in Veterinary Science, Volume 10, 2023-10-5